音频技术的发展在过去几十年的时间里,让人们的听觉体验从单声道扩展到立体声和环绕声,并且向带有高度信息的沉浸声系统快速进化。为了让年轻的音频行业从业者能够紧跟技术的快速更迭,易科国际的沉浸声技术团队于2022年5月26日,为中国传媒大学的学生们进行了一次题为《沉浸声系统在节目制作中的应用》的主题讲座。

讲座开始,中国传媒大学音乐与录音艺术学院教师贲小龙老师做了开场白,易科国际市场营销中心高级总监冀翔则介绍了易科国际的沉浸声技术团队成员以及其位于深圳总部的沉浸声系统实验及体验空间。

Part1

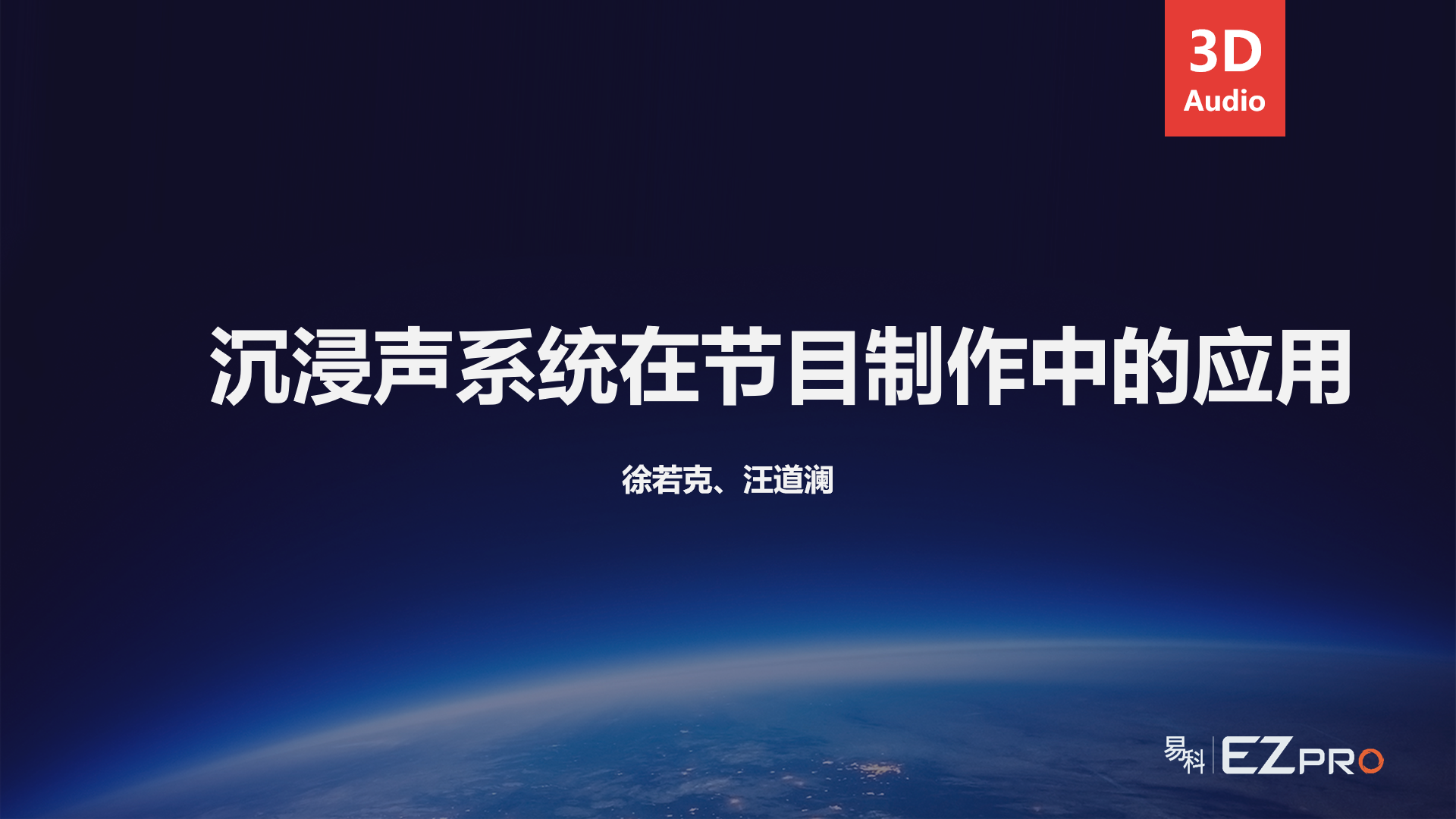

本次讲座分为三大模块:沉浸声系统基本概念梳理、节目的制作与交付流程以及沉浸声系统在应用中的相关注意事项。易科国际高级品牌经理徐若克从同学们较为熟悉的立体声和环绕声拾音制式说起,如AB,M/S,X/Y,Hamasaki Square,Fukata Tree等,让同学们对录音制作从前期拾音到后期制作,直到最后交付节目的整体流程有一个整体的把握,也为后续的沉浸声节目制作和节目交付埋下伏笔。

随后,徐若克解释了“基于声道(Channel-Based)”和“基于对象(Object-Based)”的概念,对比了二者之间的异同。

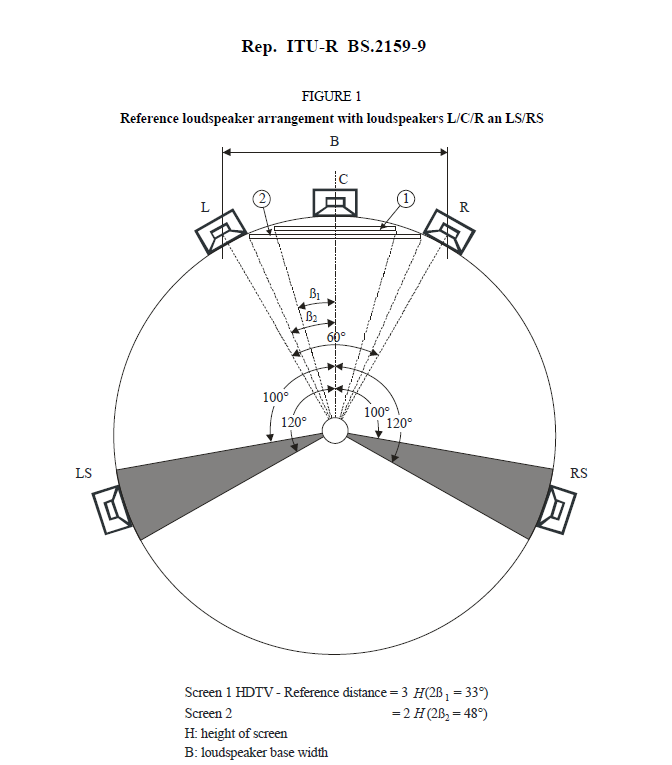

基于声道对于扬声器布局有着标准化的限制和要求,比如5.1环绕声系统对于扬声器的布局要求必须符合ITU-R BS.2159-9标准(官方链接https://www.itu.int/pub/R-REP-BS.2159-9-2022)。

基于对象则是在音频文件的基础上赋予了更多的元数据,如空间坐标信息、声学特性等。基于对象和基于声道二者之间并不是相互对立的“竞争”关系,在不同应用场景之下,作为音频工程师会选择更为合适的制作系统。对于从制作到最终节目的交付,扬声器布局遵循统一标准并且保持一致的场景,基于声道的系统有着明显的优势;若节目的制作环境和交付端无法保证扬声器布局的统一,那么为了节目迁移的一致性,基于对象的制作则有更大的优势,目前市场上的一些现场演出以及互动性较强的节目都是采用这一制作系统完成的。针对如何在基于声道和基于对象这两种系统之间做出正确的选择,除了上述的应用场景外,沉浸声引擎自身的渲染算法也是另一重要考量因素,如基于强度的VBAP,DBAP,基于延时的WFS算法,他们对于静态和动态声源的渲染上,对于系统资源的消耗有着各自的优势和不足,需要在系统设计过程中综合考量。

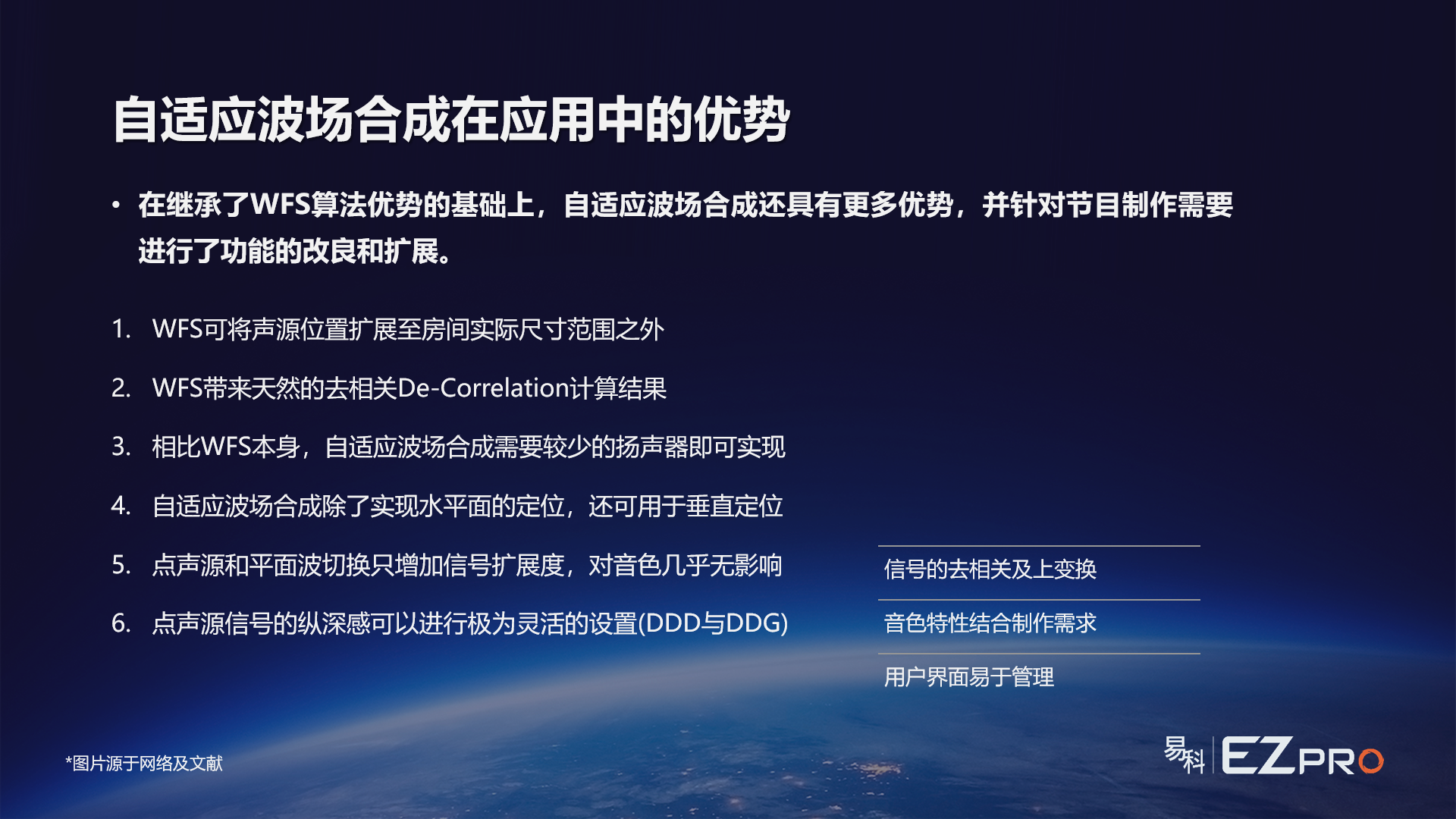

接下来,徐若克针对SARA引擎的核心算法WFS做了进一步的介绍,从WFS的理论模型到实际应用中一些难以实施的特点,让同学们不仅能够明白WFS算法的优势,同时也能够看到其在应用层面的局限性。SARA引擎的自适应波场合成渲染算法,其核心来自于WFS算法,并在及基础上做出改良和优化,所以在原有WFS的优势上,进一步减少了系统中所需扬声器的数量,更够更好的实现垂直定位,在音色保持一致的前提下,灵活地在点声源和平面波之间进行切换。

易科国际解决方案经理汪道澜在易科总部的五楼为同学们展示了SARA引擎的操作界面和简易的工作流程。从建立一个沉浸声系统工程,调整房间尺寸,建立扬声器坐标,选择扬声器类型(Spatial, Reinforcement, Sub),到针对引擎SFF格式元数据的播放器进行了功能展示,让同学们在对于沉浸声系统有了一定的理论层面认知之后,能够在引擎操作页面能够更加直观的感受到整个沉浸声系统被建立起来的过程,以及在实际应用过程中,针对不同扬声器布局,灵活且快速的比例调整。

Part2

徐若克针对沉浸声节目的制作和交付流程做了较为详细的分享。当节目进入沉浸声的制作时,大致上可以将制作方式归为完全基于对象、基于声道制作加上基于对象渲染、混合制作加上基于对象渲染这三种方式。首先,针对完全基于对象的制作方式,从制作端到节目交付端,全程都有沉浸声引擎的参与。在制作环节,工程师大多都是基于一个标准的扬声器布局完成节目的监听,沉浸声引擎作为制作环节的渲染工具,为工程师提供了基于标准扬声器布局的监听信号,而非最终交付的信号。当节目制作完成到了交付端的时候,唯一需要调整的就是交付端新的扬声器布局,这个布局需要重新导入沉浸声引擎当中,引擎接受同样的节目源,重新根据新场地的扬声器布局进行渲染,完成节目的交付。基于声道制作加上基于对象渲染可以让节目制作人员保留原有的制作流程和操作习惯,并且在制作环节可以允许沉浸声引擎不参与其中,此时制作人员听到和最终输出的文件既是监听信号又是交付信号。当制作完成之后到了交付场地,同样的,沉浸声引擎会根据场地的扬声器布局模型,针对完成的节目信号进行渲染。混合制作加上基于对象渲染这中方式,在制作环节即引入了沉浸声引擎。大部分的信号可以通过工作站的固定母线输出至引擎,少数需要做特殊效果的通道可以直接输出给引擎。在交付环节,此时的元数据既来自制作端引擎,又包含基于声道的扬声器布局,引擎基于新的扬声器布局完成节目的渲染并将信号输出给扬声器系统。

当演出现场不具备特定扬声器布局的安装条件时,沉浸声引擎基于场地中扬声器模型来渲染出虚拟扬声器来满足特定重放要求的节目,就显得非常重要。徐若克以2021年11月易科国际在星海音乐厅完成的22.2声道,8K超高清放映系列活动(点击链接查看活动原文8K超高清放映音乐会|ezacoustics携手Astro Spatial Audio为22.2声道经典录音还原“神级现场”! (qq.com))为例,和同学们分享沉浸声引擎在真实场景下的应用,团队遇到的困难和对应措施,进一步强化了沉浸声系统来渲染和还原虚拟扬声器的概念。

Part3

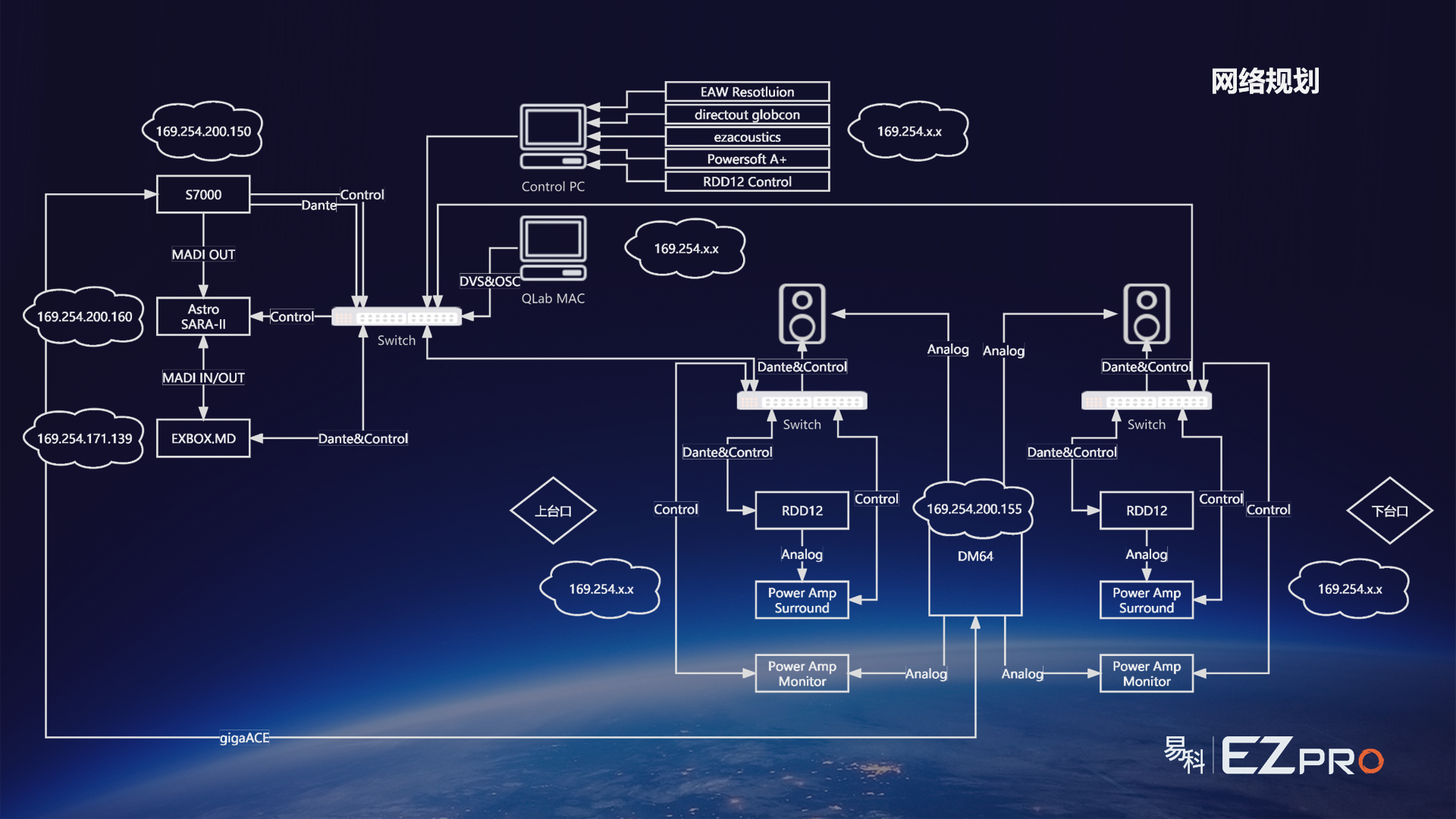

沉浸声系统在实际应用中,除了提供核心运算的沉浸声引擎,还有很多其他设备的参与,比如调音台、数字信号转换器、交换机、功放、扬声器等。当面对(设计)一套沉浸声时,我们需要全面了解各自设备在系统当中的角色。徐若克从网络规划,时钟规划的角度帮助同学们进一步了解了在应用层面会遇到的一些问题和注意事项。当我们采用Dante™作为信号传输链路的时候,我们需要明确将哪些设备规划在统一网段下。比如沉浸声主机,MADI/Dane转换盒,控制电脑需要在统一网段,以便进行沉浸声引擎的操作管理,Dante™信号流的路由监测。如果系统中有调音台和其他基于AoIP的设备,那么我们也需要将他们接入沉浸声引擎所在的网段之下。

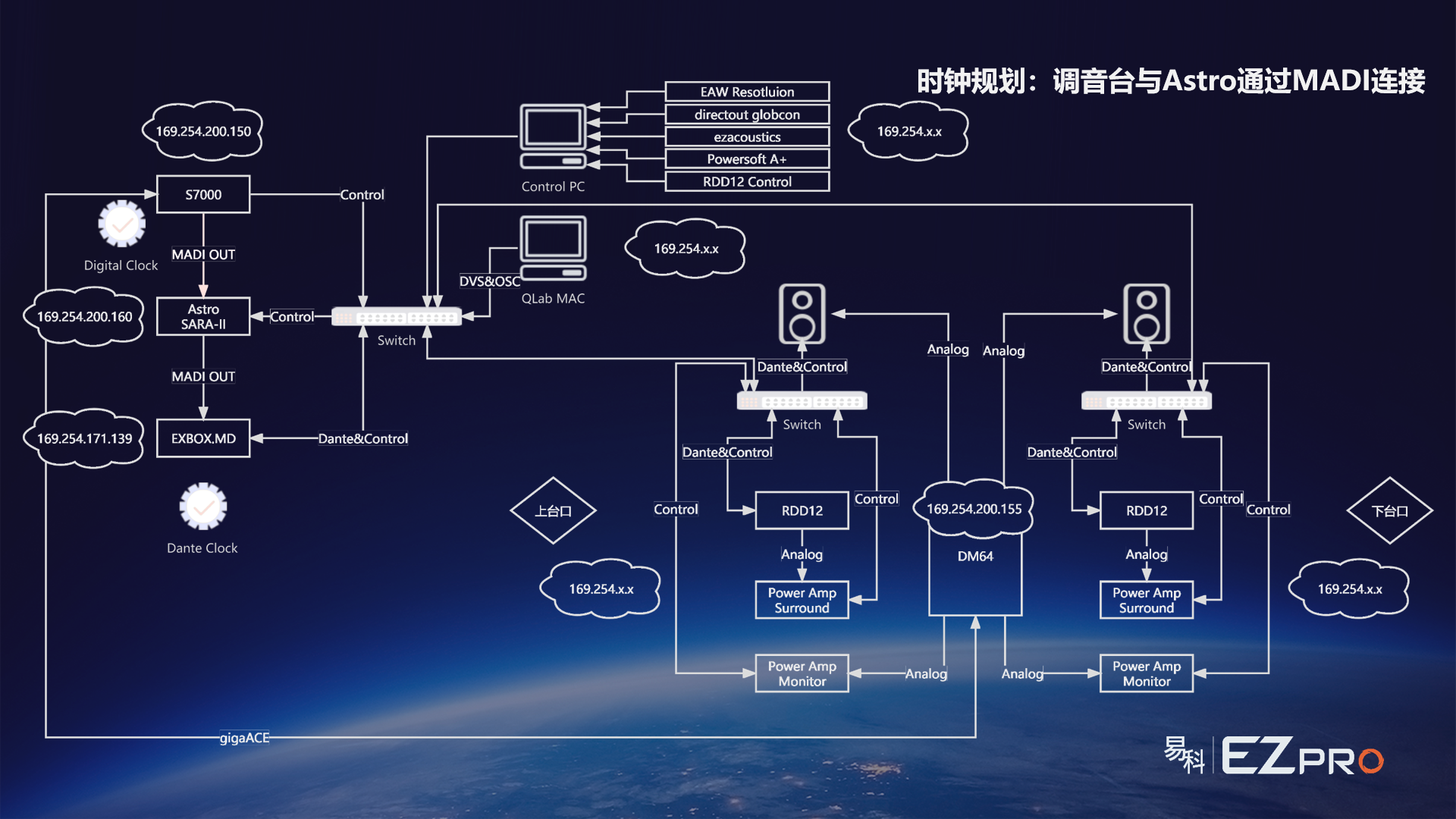

同时,在数字音频当中,时钟这一重要元素是不可忽略的。以SARA引擎为例的沉浸声系统当中,沉浸声引擎未必都是做主时钟的。根据调音台在系统中的角色变化,工程师可以将调音台作为主时钟。沉浸声引擎和后级的其他设备都可以再整个系统当中以从属状态跟随主时钟,实现数字信号的同步。由于系统中Dante™信号的存在,我们还需要考虑Dante™系统的主时钟(Master)和从设备(Slave),此处的案例当中,是以MADI/Dante信号转换器作为Dante™系统的Dante™时钟。

在讲座进行过程中,同学们都纷纷提出了关于系统设计和场地建模等多方面的问题,冀翔老师也一一进行了解答,同学们也在这短短的3个多小时的课程中有所收获。目前,由于疫情防控的相关政策要求,同学们无法亲临北京易科分公司实际上手感受这套沉浸声系统。

传媒大学贲小龙老师表示:“沉浸声制作现在已经渗透到“声音行业”的各个域,无论是基础研究、影视、音乐、游戏当然还有现场扩声。这次非常荣幸的能够邀请到易科国际的三位老师给我们做这样一次技术分享。在现场扩声中沉浸声的制作对我们来说还是一个新兴事物,通过对沉浸声节目的制作与交付以及沉浸声系统的重放等环节对同学们进行演示、讲解,能够帮助大家更好的理解课堂上老师讲授的原理及现场制作中沉浸声系统的应用现状。唯一的遗憾就是由于疫情原因无法按原定计划带着同学们到展厅内体验沉浸声制作系统,待疫情缓和希望能够有机会带领同学们到现场进行学习实践。最后还要再次感谢易科的三位老师能够为同学们提供这次宝贵的学习机会。”

通过这次的线上课程,相信能够让更多的同学能够对沉浸声系统及其应用有更多的兴趣,希望他们未来也能为音频行业,尤其是沉浸声的制作和实践注入更多的新鲜血液。